人工智能(Artificial intelligence, AI)和机器学习技术(Machine Learning Technology, ML)可能通过所提供的医疗保健中产生的大量数据获得新的重要见解,并以此影响医疗保健行业的发展。医疗机构正在将这些技术更多地应用于临床、管理和科学研究等领域。这些应用为改善医疗保健环境和治疗患者提供了独特的机会,但也带来了潜在的隐患与挑战——例如,人工智能产品提供的治疗建议有时不尽准确,这可能源于构建或训练人工智能的信息中存在的未预想到的来源偏差,也可能是由对工具所分析的某些数据点给予了不适当的权重所导致。美国食品和药物管理局(U.S. Food and Drug Administration, FDA)隶属于美国国务院保健与服务部的公共健康服务署,负责美国所有有关食品、药品、化妆品及辐射性仪器等产品的管理。自2019年4月起,FDA对于部分用于医疗保健的人工智能产品加以监管,以确保这些产品在其监管范围内的有效性与安全性。本文将对FDA在对于人工智能产品在医疗健康领域的监管规则进行综述,并概述该监管规则的监管场景、局限性、风险与挑战。

FDA监管规则的适用场景 FDA对基于人工智能的医疗产品进行监管,目的是确保其安全、有效。这一监管规则的主要标准是软件的预期用途以及其发生偏差时对患者造成风险的可能性。FDA将用于治疗、诊断、治愈、减轻或预防疾病的软件归为医疗设备,大多数基于AI或ML运作的医疗设备则被归类为“作为一种医疗器械的软件”(Software as a Medical Device, SaMD),它们旨在用于一种或多种医疗目的,并在不属于医疗设备硬件的情况下独立实现这些医疗目的,具有一定独立性。典型的SaMD包括通过分析核磁共振成像图像来帮助检测和诊断中风的软件、通过处理图像来帮助检测乳腺癌的计算机辅助检测(Computer-Aided Detection, CAD)软件等。 同医疗设备一样,由AI或ML驱动的软件都需要根据其风险性高低接受FDA不同程度的审查。一旦设备上市,FDA就会以此确定是否需要对开发人员所做的任何更改进行上市前的审查。一般而言,每当制造商对软件进行重大更新或进行其他会对设备性能产生重大影响的更改时,设备可能会受到FDA的额外审查。这一评估过程因设备的风险分类和所更改性质的不同而有所差异。需要注意的是,并非所有与健康相关的软件都属于“医疗设备”。美国国会在2016年的《21世纪治愈法案》(the 21st Century Cures Act of 2016)中将五类特定的健康软件排除于医疗设备的范围之外,如旨在为医疗机构提供行政支持的软件、旨在维持或鼓励健康的生活方式而与疾病诊断无关的软件、旨在记录患者信息的软件等等。这些软件因不属于“医疗设备”的范畴,而无需接受FDA的审查。

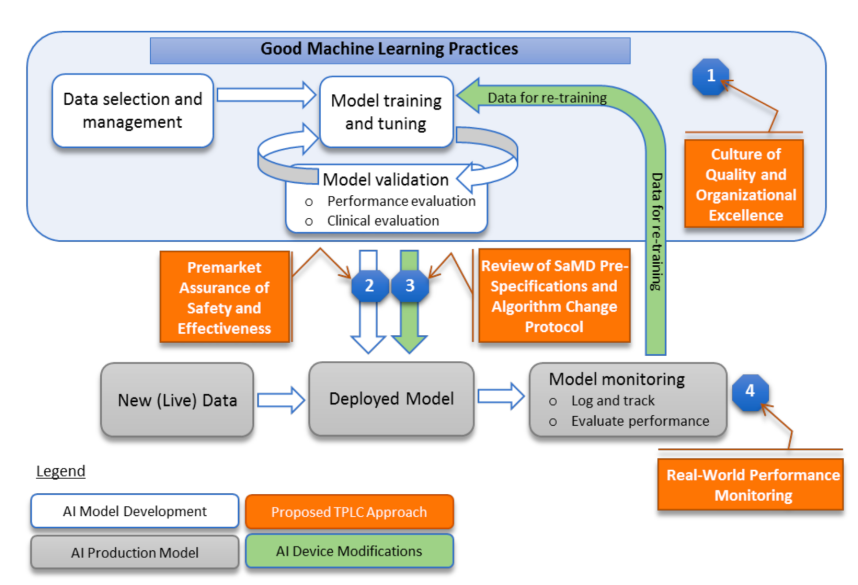

FDA的监管进展 (一)2019年4月,FDA发布初步讨论文件(Initial Discussion Paper) 此前,FDA通常在上市前审查医疗设备,常见的审查方式如上市前清关、上市前许可、申请重新分类(De Novo classification)等。对于医疗设备(包括作为医疗设备的软件)的修改,FDA还可以根据该修改的重要性以及对患者的风险性高低对其进行审查与批准。但是,这些传统的监管方式并不是为AI或ML技术设计的。据FDA预计,许多由AI或ML驱动的SaMD的修改可能也需要进行上市前审查。 2019年4月2日,FDA发布了一份《人工智能医疗器械软件变更监管框架提议(讨论稿)》(Discussion Paper: Proposed Regulatory Framework for Modification to Artificial Intelligence/Machine Learning (AI/ML)-Based Software as a Medical Device, SaMD)(以下简称“讨论文件”)。该讨论文件描述了FDA对人工智能与机器学习驱动的软件修改进行上市前审查的潜在方法的现有基础。同时,该讨论文件基于国际统一的国际医疗器械监管机构论坛(International Medical Device Regulators Forum, IMDRF)的风险分类原则、FDA的效益-风险框架、软件修改指南中的风险管理原则,以及数字医疗软件预认证(Digital Health Software Precertification, Pre-Cert)计划中设想的基于组织的TPLC方法(total product lifecycle regulatory approach),提出了基于AI或ML的SaMD的修改框架。 作为该拟议框架的一部分,FDA描述了设备上市前的“预定变更控制计划”(Predetermined Change Control Plan, PCCP)。该计划将包括预期修改的类型,即预先性能说明(SaMD Pre-Specifications, SPS)以及以受控的方式实施这些修改、致力于管理患者风险的相关方法,即算法变更协议(Algorithm Change Protocol, APC)。在这种框架下,FDA表达了对软件制造者透明度和实际性能监控的期望,这将使FDA和制造商能够评估和监控软件产品从上市前开发到上市后的性能。这一拟议框架接受了基于AI或ML的SaMD的迭代改进,将同时使FDA能够合理保证产品的安全性和有效性。但是这一框架可能需要取得额外的法定授权才能全面实施。 图1 FDA的TPLC方法对AI/ML工作流程的覆盖 为了充分实现AI或ML学习算法的强大功能,同时持续改进其性能并限制退化,FDA提出的TPLC方法以平衡收益和风险的四项原则为基础:第一,期望建立良好机器学习质量管理规范(Good Machine Learning Practice, GMLP);第二,对需要上市前提交的SaMD进行上市前审查,并希望基于AI或ML的SaMD制造者在整个产品生命周期中持续管控患者的风险;第三,希望该类产品制造者监控医疗设备,并开发、验证、执行算法修改时采用风险管理方法以及指南中的其他方法;第四,利用上市后真实性能报告,提高对用户和FDA的透明度,以持续保证设备的安全性和有效性。 需要注意的是,该文件中的建议框架仅供讨论之用,并非指南草案。此外,该文件无意传达FDA建议的(或最终实行的)监管预期,而是为了在制定指导草案之前,广泛征求政府以外的团体和个人的意见。 (二)2021年1月,FDA发布行动计划(Action Plan) 自讨论文件发布后,文件中描述的基于AI或ML的SaMD使用预定变更控制计划(Predetermined Change Control Plan, PCCP)得到了社会的广泛关注。2020年2月7日,FDA宣布,首款使用人工智能指导用户的心脏超声软件通过De Novo途径获得了上市许可。这一设备的突破性、新颖性不仅体现于其极具开拓性的新功能,还在于制造者将PCCP计划纳入了该设备的未来修改之中。 考虑到监管基于AI/ML的SaMD能够促进公共卫生领域的创新与发展,为了回应社会各界利益相关者对讨论文件的反馈意见,FDA于2021年1月发布了《基于人工智能/机器学习的软件作为医疗器械行动计划》(AI/ML-Based Software as a Medical Device Action Plan,Action Plan)(以下简称“行动计划”)。值得注意的是,“作为一种医疗器械的软件”(SaMD)指的是具备足够独立性、能够在不属于医疗设备硬件的情况下独立实现医疗目的的软件;而倘若软件独立性较低、仅成为医疗器械硬件中的组成部分,则只能被称为“医疗器械中的软件”(Software in a Medical Device, SiMD)。尽管该行动计划以SaMD为重点,但其中一些工作也可能涉及到对SiMD的监管。 该行动计划在总结、回应利益相关者的反馈的同时,确定了以下五项具体行动: 第一,为基于AI或ML的SaMD制定新的监管框架。讨论文件发布后,FDA收到了利益相关者关于SPS、ACP以及PCCP计划“重点审查”的内容、过程、时限的问题与建议,FDA致力于在制定讨论文件中提议的框架方面取得进一步进展。对于引起社会广泛关注的PCCP计划,FDA后续于2021年发布了一份指南草案,即后文中的《人工智能/机器学习支持设备软件功能的预定变更控制计划的营销提交建议的指南草案》,以征询该领域的社会公众意见。 第二,鼓励协调GMLP。利益相关者大力支持GMLP的理念,并要求FDA鼓励协调制定GMLP的众多努力,包括通过协商一致的标准努力、利用现有的工作流程以及让关注AI、ML的其他公众共同协作。FDA一直积极进行并将不断致力于深化在各个社区的这些工作,以鼓励达成有利于AI或ML技术开发与监督的共识。为了履行FDA对医疗器械网络安全采取有力措施的长期承诺,这些GMLP工作将与该局的医疗器械网络安全计划密切合作。 第三,举行公开研讨会,讨论设备标签如何为用户提供透明度,增强用户对基于AI/ML的SaMD的信任。2020年10月,FDA的患者参与咨询委员会(Patient Engagement Advisory Committee, PEAC)召开会议,以了解患者视角下影响他们对这些技术的信任的因素。在对本次会议收集的意见进行整理的同时,FDA通过举办公开研讨会的形式,分享了经验教训,并征求了更广泛群体的意见,以更好地了解设备标签如何提高对用户的透明度。 第四,支持监管科学开发评估和改进机器学习算法的方法的努力,包括识别和消除歧视,以及评估并提高算法的稳健性。医疗保健服务会因患者的种族、民族和社会经济地位等因素而有所不同,而医疗保健系统中存在的偏见可能会无意中引入算法中。FDA认识到,医疗设备必须适用于不同种族和民族的目标患者群体,并且识别和改进ML算法的方法亟需改进——这包括识别并消除偏见的方法,以及提高算法的稳健性与弹性,以承受不断变化的临床输入和条件。 第五,与正在为基于AI或ML的SaMD试行“真实世界性能”(Real-World Performance, RWP)流程的利益相关者合作。利益相关者对讨论文件中提出的“收集SaMD实际使用的性能数据”的方法提出了许多疑问,包括:在测试软件设备的性能时,适合使用什么类型的参考数据?利益相关者应当进行何种程度的监督?每个利益相关者应该进行多少监督?向FDA提供数据的数量及频率分别是怎样的?如何将最终用户的反馈纳入基于AI/ML的SaMD的培训和评估中?诸如此类的疑问无一不在表明该领域亟需修正并明确方向。FDA将通过与利益攸关方在自愿基础上合作,共同支持监测实际业绩的尝试。这项工作旨在帮助FDA开发一个可用于在现实世界中收集并验证基于AI或ML的SaMD的相关RWP参数与指标的框架。 (三)2023年4月,FDA发布指南草案(Draft Guidance) 2023年4月3日,FDA发布于了《人工智能/机器学习支持设备软件功能的预定变更控制计划的营销提交建议的指南草案(Marketing Submission Recommendations for a Predetermined Change Control Plan for Artificial Intelligence/Machine Learning (AI/ML)-Enabled Device Software Functions, Draft Guidance)(以下简称“指南草案”)》。该指南草案提出了一种通过修改机器学习设备软件功能(machine learning device software function, ML-DSF)以支持迭代更新的方法,并继续为设备的安全性、有效性提供合理的保证。截至今年7月3日,FDA接受社会各界对指南草案的评价。 指南草案适用于制造者打算长期修改的ML-DSF,无论这种修改是自动或手动。指南草案中的PCCP计划共有三个要素:修改说明、修改协议、影响评估。除了在PCCP计划中已预先计划的修改之外,其他修改都需要在上市前获得批准、重新提交或在上市前重新通知。 1. 修改说明 PCCP必须包含对计划内的设备修改的详细、具体描述,包括对单个设备修改的罗列清单、ML-DSF各部分修改的理由、与每次修改有关的参考变更的标签。FDA建议PCCP中的特定修改是可验证和可确认的,这些修改应足够详细以能够被理解。同时,修改说明应清楚表明计划的修改是自动还是手动实施。并非一切修改都适合被包含在PCCP中,PCCP中的修改类型包括与ML-DSF的性能规格的定量测量有关的修改、与ML-DSF的设备输入有关的修改,以及与设备的使用和性能相关的特定有限修改。 2. 修改协议 修改协议描述了用于开发、验证和实施这些修改的方法,包括数据管理实践、再培训实践、性能评估、更新程序四个要素。每个要素都应满足对应的要求,以保证设备具有长期的安全性、有效性。修改说明中提出的修改应能够在设备的现有质量体系中进行验证和验证,PCCP中可接受的修改包括与ML-DSF性能规范的定量测量、设备输入有关的修改,以及部分与设备的使用和性能相关的特定的修改。 3. 修改评估 指南草案中的“影响评估”,是对实施PCCP所带来的益处和风险进行评估的文件。影响评估注意考虑到以下五个要素:第一,将修改前后的设备进行比较;第二,对每项修改进行效益与风险的评估,包括社会危害风险;第三,讨论修改中建议的活动如何继续合理地确保设备的安全性和有效性;第四,一项修改对另一项修改的影响;第五,实施所有修改的总体影响。上市申请中的影响评估文件应不仅讨论PCCP中包含的个别修改如何影响ML-DSF,还会讨论如何影响其他设备软件功能以及设备硬件的整体功能。 FDA监管规则的局限性与不足之处 随着人工智能产品在医疗保健领域的使用激增,FDA和其他利益相关者需要针对证明此类产品的安全性和有效性所需的临床证据,以及产品标签明确其性能和通用性的限制程度,制定明确的指南。FDA的行动计划与指南草案标志着该机构监管规则的进步,但以下问题仍未被阐明:如何界定某一类产品是否受FDA监管,何时需要上市审查,GMLP在制定时与现有的设备质量法规体系的交叉之处,以及如何向最终用户告知软件更新以及更新对性能的潜在影响等。 FDA于2023年6月14日发布《最终指南:器械软件功能上市前提交内容》(Content of Premarket Submissions for Device Software Functions),旨在为FDA评估器械软件功能的安全性和有效性提供有关上市前提交推荐文件的信息,其中包括部分使用通过机器学习方法训练的机器学习模型的软件设备功能。由于部分产品(尤其是不受FDA授权的人工智能软件)不属于“医疗设备”的范畴,可能需要其他的监督机构加以监管。此外,为了充分发挥AI之于医疗健康领域的潜在价值,以及最大限度地确保患者的安全,FDA可能需要与医疗认证机构、私营技术公司等各种利益相关者建立伙伴关系,并可能需要得到国会的额外授权,才能够真正将预认证试点等政策提议实际实施。 人工智能在医学领域应用尚存的风险与挑战 随着人工智能技术的不断成熟,FDA的监管规则对于人工智能在医疗健康领域的应用作出了可观的努力。但尽管如此,人工智能在数据、算法、计算和应用各个环节中的风险与挑战仍然不容忽视。其中,较为显著的风险包括数据准确度欠佳、数据完整度不足以及个人隐私数据保护问题、算法歧视问题等,人工智能在医学领域落地亟需解决此类问题。 (一)数据准确度、完整度问题 人工智能产品需要在大型、多样化的数据基础上进行训练,以便在各种人群中推广使用,并确保它们的准确性与可靠性。然而,目前数据基础在其质量、获取方式、完整度上均存在缺陷,未能良好地服务于人工智能发展。一方面,根据美国加州大学旧金山医疗中心电子病案系统的数据分析,大量以文本形式录入的数据存在复制、粘贴他人医疗记录的嫌疑,其准确度受到质疑。信息的失效、偏差、错误与冗余,最终可能造成严重的误诊。另一方面,由于美国各州医疗保健系统的碎片化,患者繁多,存在大量未录入、未在系统中联通的健康记录,缺乏合理的数据共享与数据流通的机制,组装完整数据集的成本总体上非常高昂。这可能会增加由于数据集不完整或来自多个来源的数据不当合并而造成的错误可能性。 (二)个人隐私数据保护问题 为人工智能产品的运行收集足够多的患者数据,可能会引发有关数据隐私和个人健康数据所有权的复杂问题。一些卫生系统正在与科技公司和数字初创公司共享患者数据,以研发人工智能项目,患者对此可能并不知情。有关患者是否应该同意共享他们的数据,以及他们是否应该对公司等外部实体使用他们的个人数据所开发的产品享有利润等问题,目前仍存在广泛争议。 (三)算法歧视问题 数据收集方面的挑战和医疗卫生系统内部的不平等导致人工智能项目存在歧视,这会影响到产品的安全性和有效性,并进而导致以少数群体为代表的许多人群无法得到适当、充分的治疗。倘若在某类人群中很少或几乎没有进行基因研究,那么旨在根据基因预测结果的算法就会产生偏差。例如,弗雷明汉心脏研究(Framingham Heart Study)的数据主要源于白人患者,试图使用上述数据来预测非白人种群和族裔人群心血管疾病风险的做法会导致偏见性结果。另外,人工智能在分析医疗保险投保人的个人特征时也存在产生“歧视”倾向,对于某些特殊疾病患者或具有疾病高风险因素的患者可能收取更高的费用。由此,算法歧视带来的法律、伦理挑战仍然普遍存在,不容忽视。 结语 随着医疗诊疗方法和技术不断更新,医疗人工智能的应用日益广泛,对其进行监管以实现良性发展是时势所趋。FDA对医疗人工智能的监管规则旨在确保人工智能驱动的医疗产品使用时的安全性和有效性,标志着政府部门对该领域风险的关注与重视,是该行业发展的一大进步。从2019年发展至2023年间,FDA的监管规则由一份初步讨论文件,逐渐发展为行动计划,目前已形成一份指南草案。然而,需要承认的是,目前的监管规则尚不够成熟,仍有一些实际性问题需要进一步阐明。对于FDA的监管范畴、如何与现有设备质量体系配合等具体问题,还亟需更多的研究和讨论。 面对人工智能在医学领域应用的风险与挑战,人类应当如何进行监管与保护,以使医疗产品安全有效、实现良性的应用与发展?尽管FDA的监管框架尚未正式实施,但它提供了重要的指导方针,为医疗人工智能的监管提供了一份可行的方案。随着监管框架不断完善、监管措施不断健全,人工智能必将更好地服务于医疗行业,维护人类健康。 [1] Daniel, G., Silcox, C., Sharma, I. and Wright, M., 2019. Current state and near-term priorities for AI-Enabled diagnostic support software in health care. Duke Margolis Center for Health Policy. [2] Char, D.S., Shah, N.H. and Magnus, D., 2018. Implementing machine learning in health care—addressing ethical challenges. The New England journal of medicine. [3] Food and Drug Administration, 2019. Proposed regulatory framework for modifications to artificial intelligence/machine learning (AI/ML)-based software as a medical device (SaMD). [4] Food and Drug Administration, 2021. Artificial Intelligence/Machine Learning (AI/ML)-Based Software as a Medical Device (SaMD) Action Plan. [5] https://www.fda.gov/regulatory-information/search-fda-guidance-documents/marketing-submission-recommendations-predetermined-change-control-plan-artificial [6] https://www.pewtrusts.org/en/research-and-analysis/issue-briefs/2021/08/how-fda-regulates-artificial-intelligence-in-medical-products [7] FDA, Deciding When to Submit a 510(k) for a Change to an Existing Device[EB/OL], https//www.fda.gov/regulatory-information/search-fda-guidance-documents/deciding-when-submit-510k-change-existing-device. [8] https://mofotech.mofo.com/topics/fda-publishes-draft-guidance-predetermined-change-control-plan-for-ai-ml-enabled-device-software-functions [9] U.S. Government Accountability Office and National Academy of Medicine, “Artificial Intelligence in Health Care: Benefits and Challenges of Machine Learning in Drug Development” (2019), www.gao.gov/assets/gao-20-215sp.pdf. [10] Food and Drug Administration, 2023. Content of Premarket Submissions for Device Software Functions.